Un lungo e complicato percorso

Il 14 giugno 2023, il Parlamento europeo ha approvato l’Artificial Intelligence Act, un regolamento che regola l’uso dell’intelligenza artificiale nell’Unione Europea.

La legge prevede norme specifiche per la protezione dei diritti fondamentali, la trasparenza e la responsabilità nell’utilizzo dell’IA.

L’UE regolamenta l’Intelligenza Artificiale per garantire lo sviluppo e l’utilizzo ottimali.

Nell’aprile del 2021, la Commissione Europea ha presentato il primo quadro normativo dell’Unione Europea per l’Intelligenza Artificiale. Questa proposta di regolamentazione dell’IA è stata sviluppata per proteggere i diritti dei cittadini e promuovere l’innovazione tecnologica in modo etico e sicuro.

L’obiettivo è garantire l’utilizzo responsabile dell’IA per evitare impatti negativi sulla società e sull’ambiente. Il quadro normativo definisce anche le condizioni per l’uso dell’IA in settori come la salute, il trasporto, l’energia e la pubblica amministrazione.

I sistemi di intelligenza artificiale sono sempre più diffusi in diversi settori, come la medicina, l’industria automobilistica e la sicurezza informatica.

La proposta di regolamento sull’Intelligenza Artificiale (IA) dell’Unione Europea (UE) mira a instillare fiducia nell’utilizzo dell’IA da parte degli europei.

Nonostante la maggior parte dei sistemi di IA non presenti rischi, alcuni di essi possono avere conseguenze indesiderate. L’obiettivo è affrontare tali rischi in modo che l’IA possa contribuire a risolvere diverse sfide sociali.

La comprensione del ragionamento alla base delle decisioni o previsioni di un sistema di IA può risultare difficile, rendendo complicato valutare eventuali svantaggi ingiusti in situazioni come la selezione del personale o la richiesta di servizi pubblici.

Analizzare e classificare i rischi per gli utenti è fondamentale considerando la sicurezza dei dati e la possibilità di errori.

In questo modo, si può garantire che i sistemi di intelligenza artificiale siano sicuri ed efficienti per gli utenti.

I diversi livelli di rischio significheranno più o meno regolamentazione.

È il primo regolamento sull’Intelligenza Artificiale al mondo, che regola lo sviluppo, la commercializzazione e l’utilizzo dei sistemi di IA.

L’AI Act è stato creato per garantire che lo sviluppo dell’Intelligenza Artificiale rispetti i valori e i diritti dell’Unione Europea.

“Scopo del presente regolamento è promuovere l’adozione di un’intelligenza artificiale antropocentrica e affidabile e garantire un elevato livello di protezione della salute, della sicurezza, dei diritti fondamentali, della democrazia e dello Stato di diritto e dell’ambiente dagli effetti nocivi dei sistemi di intelligenza artificiale nell’Unione, sostenendo allo stesso tempo l’innovazione”.

“una legislazione che senza dubbio stabilirà lo standard globale per gli anni a venire”.

L’UE e gli USA hanno invitato a implementare le norme dell’AI Act prima della conclusione dell’iter continentale per tracciare un confine utile per una regolamentazione globale.

Ciò garantirà l’etica e la responsabilità nell’utilizzo di questa tecnologia in rapida evoluzione.

Inoltre, si è evidenziata l’importanza di introdurre un codice di condotta volontario per le principali aziende che sviluppano software di intelligenza artificiale per garantire una maggiore trasparenza e sicurezza nell’utilizzo di questa tecnologia.

La posizione del Parlamento Europeo

La priorità del Parlamento europeo è garantire che i sistemi di intelligenza artificiale utilizzati nell’Unione Europea siano sicuri, trasparenti, tracciabili, non discriminatori e rispettosi dell’ambiente.

Tali sistemi dovrebbero essere progettati in modo affidabile e prevedibile per evitare qualsiasi rischio per la sicurezza o la privacy delle persone. Inoltre, essi dovrebbero essere trasparenti, in modo che gli utenti possano comprendere il loro funzionamento e come vengono utilizzati i loro dati.

Infine, dovrebbero essere tracciabili, in modo che sia possibile risalire alle decisioni prese dai sistemi di intelligenza artificiale e verificare che siano state prese in modo equo e non discriminatorio.

L’importanza di garantire la massima sicurezza e affidabilità dei sistemi di intelligenza artificiale è sempre più rilevante nella vita quotidiana delle persone, sia nel campo della salute che del lavoro.

Il Parlamento intende stabilire una definizione uniforme e tecnologicamente neutra dell’intelligenza artificiale, al fine di applicarla ai sistemi futuri.

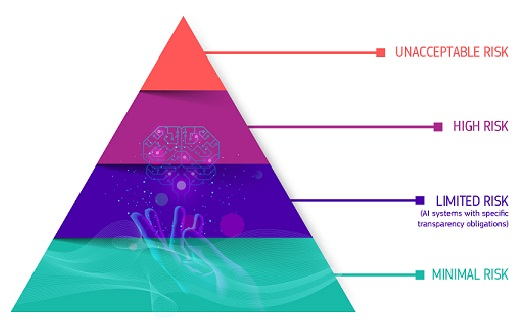

AI Act: regole diverse per diversi livelli di rischio

Il regolamento introdotto ha lo scopo di garantire la sicurezza, la trasparenza e l’etica dell’Intelligenza Artificiale in Europa.

La normativa dell’UE regola l’uso dell’intelligenza artificiale attraverso un sistema chiamato risk-based approach, che impone obblighi di conformità diversi a seconda del rischio di danno ai diritti fondamentali causato dal software e dall’IA.

Anche se molti sistemi di intelligenza artificiale comportano rischi minimi, è importante valutare attentamente i rischi potenziali prima di utilizzarli.

Rischio inaccettabile

Rischio inaccettabile I sistemi di intelligenza artificiale sono considerati una minaccia per le persone e saranno vietati.

Divieto di riconoscimento delle emozioni tramite IA.

Il progetto di testo del Parlamento europeo propone una legge che vieta l’utilizzo dell’Intelligenza Artificiale per il riconoscimento delle emozioni in determinati contesti, come ad esempio nelle forze dell’ordine, nelle istituzioni scolastiche e nei luoghi di lavoro.

La legge vieta l’utilizzo della tecnologia di identificazione biometrica a distanza in luoghi pubblici, salvo alcune eccezioni specifiche.

Tali eccezioni includono la ricerca di un minore disperso, la prevenzione di una minaccia terroristica specifica e imminente, nonché l’individuazione, la localizzazione, l’identificazione o la persecuzione di un autore o un sospetto di un reato grave.

Leggi anche Diritto Rovescio –

Giove – La polizia predittiva che non ha previsto l’AI ACT?

L’impiego dell’intelligenza artificiale per la rilevazione e l’analisi facciale ha ricevuto critiche in passato a causa della sua imprecisione e dei pregiudizi. Tuttavia, la bozza del testo delle altre due istituzioni non ha vietato l’utilizzo di tale tecnologia.

La decisione di applicare o meno il divieto nella legge rappresenterà una grande battaglia legislativa tra i vari organi dell’UE.

Tuttavia, l’uso di questa tecnologia richiede l’autorizzazione di un organo giudiziario o di un altro organo indipendente e deve essere limitato nel tempo, nella portata geografica e nelle banche dati consultate.

I sistemi di intelligenza artificiale possono essere considerati a rischio inaccettabile e quindi vietati, quando rappresentano una minaccia per la sicurezza, i mezzi di sussistenza e i diritti delle persone.

In particolare, facciamo riferimento a:

- Punteggio sociale: classificazione delle persone in base al comportamento, allo stato socioeconomico o alle caratteristiche personali

- Sistemi di identificazione biometrica in tempo reale e remota, come il riconoscimento facciale

- Sistemi di intelligenza artificiale che utilizzano tecniche subliminali o tecniche manipolative o ingannevoli per distorcere il comportamento;

- Sistemi di intelligenza artificiale che sfruttano le vulnerabilità di individui o gruppi specifici;

- Sistemi di categorizzazione biometrica basati su attributi o caratteristiche sensibili;

- Sistemi di IA utilizzati per la valutazione del rischio che prevedono reati penali o amministrativi;

- Sistemi di intelligenza artificiale che creano o espandono database di riconoscimento facciale attraverso web scraping non mirato;

- Sistemi di intelligenza artificiale che deducono le emozioni nelle forze dell’ordine, nella gestione delle frontiere, sul posto di lavoro e nell’istruzione.

Alto rischio

I sistemi di intelligenza artificiale che rappresentano una minaccia per la sicurezza o i diritti fondamentali saranno considerati ad alto rischio.

L’alto rischio corrisponde a un “rischio significativo” di danno alla salute, alla sicurezza o ai diritti fondamentali, inteso come “risultato della combinazione della sua gravità, intensità, probabilità di accadimento e durata dei suoi effetti e la capacità di colpire un individuo, una pluralità di persone o un particolare gruppo di persone”

La salute umana è strettamente correlata all’ambiente circostante, pertanto è importante considerare anche le infrastrutture critiche come le reti energetiche o i sistemi di gestione dell’acqua. Per garantire la protezione dell’ambiente, i sistemi basati sull’intelligenza artificiale devono rispettare gli standard ambientali europei e gli standard di impronta ecologica.

Divieto di Social Scoring: Il sistema di credito sociale, che prevede l’assegnazione di un punteggio alle persone in base al loro comportamento, non può essere utilizzato dalle agenzie pubbliche per effettuare generalizzazioni o profilazioni. Tale pratica è vietata per legge.

Il Parlamento europeo ha adottato nuove restrizioni per i sistemi di intelligenza artificiale che potrebbero influenzare gli elettori e l’esito delle elezioni.

Queste restrizioni si applicano anche agli algoritmi di raccomandazione utilizzati sui social media e altre piattaforme digitali. I sistemi di intelligenza artificiale che rientrano in questa categoria saranno considerati a rischio elevato e saranno sottoposti a controlli più rigorosi per garantire la loro trasparenza e responsabilità.

Di seguito sono elencati i sistemi di intelligenza artificiale identificati come “ad alto rischio” utilizzati in diversi contesti:

- infrastrutture critiche (ad esempio i trasporti), che potrebbero mettere a rischio la vita e la salute dei cittadini;

- formazione educativa o professionale, che può determinare l’accesso all’istruzione e al corso professionale della vita di qualcuno (ad esempio il punteggio degli esami);

- componenti di sicurezza dei prodotti (ad es. AI nella chirurgia assistita da robot);

- occupazione, gestione dei lavoratori e accesso al lavoro autonomo (ad esempio software di selezione dei Curriculum Vitae per le procedure di assunzione);

- servizi privati e pubblici essenziali (ad esempio, l’utilizzo del sistema di credit scoring – misura quantitativa sintetica che riguarda l’affidabilità creditizia di un determinato soggetto – che può negare ai cittadini la possibilità di ottenere un prestito);

- applicazione della legge che può interferire con i diritti fondamentali dei cittadini;

- gestione della migrazione, dell’asilo e del controllo delle frontiere (ad esempio, la verifica dell’autenticità dei documenti di viaggio);

- amministrazione della giustizia e processi democratici.

Tutti i sistemi di identificazione biometrica remota sono considerati ad alto rischio e sono soggetti a severi requisiti.

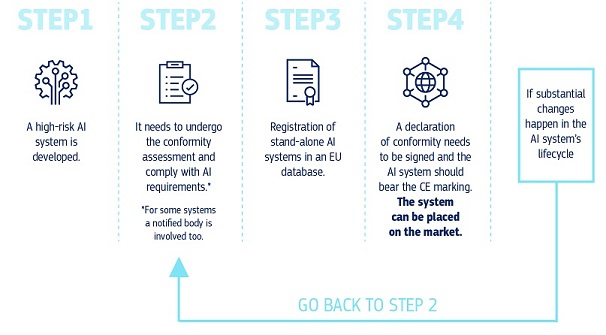

In base alle nuove regole dell’Unione Europea, i sistemi di Intelligenza Artificiale (IA) ad alto rischio, come quelli utilizzati in ambito sanitario o per il controllo dei veicoli autonomi, dovranno rispettare obblighi rigorosi prima di essere immessi sul mercato.

Tali obblighi includono la presenza di un adeguato sistema di valutazione e mitigazione dei rischi, l’offerta di informazioni chiare e complete all’utente, la disponibilità di documentazione dettagliata che fornisca tutte le informazioni necessarie sul sistema e sul suo scopo, in modo che le autorità possano valutarne la conformità, oltre alla registrazione delle attività al fine di garantirne la tracciabilità dei risultati.

Tutti i sistemi di IA ad alto rischio saranno valutati prima di essere immessi sul mercato e anche durante tutto il loro ciclo di vita.

- adeguati sistemi di valutazione e mitigazione dei rischi;

- elevata qualità delle serie di dati che alimentano il sistema per ridurre al minimo i rischi e i risultati discriminatori;

- registrazione dell’attività per garantire la tracciabilità dei risultati;

- documentazione dettagliata che fornisca tutte le informazioni necessarie sul sistema e sul suo scopo per le autorità di valutarne la conformità;

- informazioni chiare e adeguate all’utente;

- adeguate misure di sorveglianza umana per ridurre al minimo il rischio;

- elevato livello di robustezza, sicurezza e precisione.

L’articolo 10 dell’AI Act stabilisce che i fornitori di sistemi di Intelligenza Artificiale ad alto rischio, che utilizzano tecniche basate sui dati per addestrare i modelli, possono trattare solo le categorie di dati personali strettamente necessarie per garantire il monitoraggio, il rilevamento e la correzione delle distorsioni.

Questa restrizione mira a proteggere la privacy degli individui e a garantire che i fornitori di sistemi di IA adottino misure adeguate per gestire i dati personali sensibili.

IA generativa

L’intelligenza artificiale generativa, come ChatGPT, dovrebbe rispettare i requisiti di trasparenza:

- Divulgare che il contenuto è stato generato dall’intelligenza artificiale

- Progettare il modello per evitare che generi contenuti illegali

- Pubblicazione di riepiloghi dei dati protetti da copyright utilizzati per la formazione

- i modelli di Intelligenza Artificiale generativa, come ChatGPT di OpenAI e Bard di Google, potranno operare a condizione che i loro risultati siano chiaramente identificati come generati dall’IA

Rischio limitato

I sistemi di Intelligenza Artificiale a rischio limitato sono stati progettati per ridurre al minimo i rischi per gli utenti.

Tuttavia, è importante che questi sistemi rispettino determinati requisiti di trasparenza, in modo che gli utenti possano prendere decisioni informate dopo aver interagito con le applicazioni.

Quando si utilizzano sistemi di intelligenza artificiale, come i chatbot, è importante che gli utenti siano informati di interagire con una macchina. In questo modo, possono decidere in modo consapevole se continuare o interrompere l’interazione.

È fondamentale informare gli utenti quando interagiscono con l’IA, compresi i sistemi che generano o manipolano contenuti di immagini, audio o video, come ad esempio i deepfake.

Tutto ciò che include applicazioni come videogiochi abilitati all’intelligenza artificiale o filtri antispam rientra nella categoria a basso rischio.

Rischio minimo o nullo

La proposta suggerisce l’utilizzo di sistemi di Intelligenza Artificiale a basso rischio, come ad esempio videogiochi dotati di intelligenza artificiale o filtri antispam.

Questi sistemi sono già ampiamente utilizzati nell’Unione Europea e rappresentano una soluzione accessibile per molte aziende e sviluppatori.

La regolamentazione varierà in base al livello di rischio associato.

Una volta che un sistema di intelligenza artificiale (IA) viene commercializzato, è importante che le autorità garantiscano la sicurezza e l’efficacia del prodotto attraverso la vigilanza del mercato.

Per prevenire eventuali problemi e malfunzionamenti, gli utenti del sistema sono tenuti a fornire una sorveglianza umana costante.

Inoltre, i fornitori del sistema sono obbligati a mettere a disposizione un sistema di monitoraggio post-commercializzazione per rilevare eventuali malfunzionamenti o incidenti gravi. Nel caso in cui si verifichino problemi, sia i fornitori che gli utenti devono segnalare immediatamente gli incidenti alle autorità competenti.

I prossimi passi

Una volta presentata la proposta di legge, si daranno inizio ai colloqui con gli Stati membri dell’UE all’interno del Consiglio per discutere e definire la versione finale della legge.

L’obiettivo è quello di raggiungere un accordo entro la fine dell’anno in modo da garantire una soluzione tempestiva e soddisfacente per tutte le parti coinvolte. L’approccio comune e condiviso in Europa su questo tema è fondamentale per una gestione efficace e coordinata della questione.

‘Europa avanza sulla regolamentazione dell’IA, compiendo un passo fondamentale verso l’approvazione di restrizioni storiche dell’Intelligenza Artificiale.

I negoziati trilaterali per il testo finale sono attualmente in corso di perfezionamento.

Si prevede che tali negoziati saranno completati entro la fine dell’anno, con l’obiettivo di approvare la legge prima delle elezioni del Parlamento europeo nel giugno 2024.

L’istituzione di un comitato europeo per l’intelligenza artificiale e la scelta su chi nominare a livello nazionale

In vista dell’entrata in vigore definitiva del (AI ACT), gli Stati membri dell’Unione Europea dovranno designare un’autorità nazionale responsabile della supervisione dell’applicazione del Regolamento.

Ci sono motivazioni sostanziali e organizzative che giustificano la nomina del Garante privacy come tale autorità.

Gli Stati membri dell’UE si trovano di fronte ad una decisione cruciale

- creare un’autorità di controllo specifica

- affidare le funzioni e le responsabilità a un ente già esistente.

Se necessario per ragioni organizzative e amministrative, uno Stato può nominare più di un’autorità per il controllo di un determinato settore.

È possibile assegnare la funzione di controllo ad un’autorità indipendente esistente a patto che abbia le competenze necessarie.

In base all’articolo 59 dell’AI Act, è richiesto che le autorità nazionali competenti dispongano di personale adeguato e permanentemente disponibile, dotato di competenze e conoscenze adeguate che comprendano una conoscenza approfondita delle tecnologie, dei dati e del calcolo dei dati di intelligenza artificiale.

Tale personale dovrebbe essere in grado di comprendere i diritti fondamentali, i rischi per la salute e la sicurezza e le norme e i requisiti giuridici esistenti.

A livello nazionale, ogni Stato membro dell’Unione Europea dovrà nominare una o più autorità nazionali competenti per la regolamentazione dell’intelligenza artificiale.

Questo permetterà di garantire l’efficacia e la sicurezza dei sistemi di intelligenza artificiale utilizzati in Europa.

A livello dell’Unione Europea, il Regolamento sull’Intelligenza Artificiale prevede la creazione di un Comitato Europeo per l’Intelligenza Artificiale.

Il comitato presieduto dalla Commissione UE e composto dai rappresentanti degli Stati e dal Garante Europeo della Protezione dei Dati, ha il compito di

agevolare l’attuazione uniforme del Regolamento sull’Intelligenza Artificiale

promuovere la cooperazione tra le autorità nazionali di controllo e la Commissione UE

fornire consulenza alla Commissione UE per garantire una regolamentazione efficace e agevole dell’Intelligenza Artificiale nell’ambito dell’UE

tutelare i diritti dei cittadini europei in materia di protezione dei dati.

E in Italia?

In passato, nel 2005, l’Autorità Garante della Concorrenza e del Mercato è stata scelta come l’autorità competente per l’applicazione della normativa sulle pratiche commerciali scorrette verso i consumatori.

Di recente, poche settimane fa, è stata selezionata l’Autorità per le Garanzie nelle Comunicazioni come l’autorità competente per l’applicazione del DSA, il Digital Services Act.Ora che il processo di approvazione dell’AI Act è in fase avanzata, l’Italia deve decidere se creare un’autorità di controllo specifica per l’AI o affidare le sue funzioni e responsabilità ad un’autorità indipendente già esistente.

In passato, nel 2005, l’Autorità Garante della Concorrenza e del Mercato è stata scelta come l’autorità competente per l’applicazione della normativa sulle pratiche commerciali scorrette verso i consumatori.

Di recente, poche settimane fa, è stata invece selezionata l’Autorità per le Garanzie nelle Comunicazioni come l’autorità competente per l’applicazione del DSA, il Digital Services Act.

Il Comitato europeo per la protezione dei dati (EDPB) e il Garante europeo della protezione dei dati (GEPD) hanno pubblicato il parere congiunto 5/2021, che si concentra sulla protezione dei dati personali nell’utilizzo di sistemi di intelligenza artificiale.

Il parere raccomanda che le autorità nazionali competenti per la protezione dei dati siano incaricate delle funzioni e delle responsabilità di autorità di controllo per garantire l’efficace attuazione del Regolamento generale sulla protezione dei dati (GDPR) nel contesto dell’intelligenza artificiale.

Inoltre, il parere sottolinea che le disposizioni dell’AI Act sono strettamente collegate al quadro giuridico di protezione dei dati quando si tratta di utilizzo di sistemi di intelligenza artificiale che comportano il trattamento di dati personali.

La designazione delle autorità per la protezione dei dati come autorità nazionali di controllo aiuterebbe a garantire un’armonizzazione normativa tra gli Stati membri dell’Unione Europea e una corretta interpretazione delle disposizioni sulla gestione dei dati.

Ciò impedirebbe contraddizioni nella loro applicazione tra i vari Stati membri.

Inoltre, è importante notare che alcuni Stati membri dell’Unione Europea, come la Francia, stanno esplorando diverse idee per la regolamentazione dell’Intelligenza Artificiale (IA).

Ad esempio, il Consiglio di Stato francese ha pubblicato uno studio nel 2022 che raccomanda una profonda trasformazione del CNIL (l’autorità nazionale di controllo per la protezione dei dati personali) in un organo con poteri di regolamentazione e sorveglianza anche sui sistemi di IA, in particolare quelli pubblici.

Dirittorovescio l regolamento tarda ad arrivare. nel frattempo ci pensano le singole autorità nazionali – il caso francese (cnil)

A un livello sostanziale, la protezione dei dati personali e la disciplina dell’intelligenza artificiale sono strettamente interconnesse in quanto entrambe sono orientate al mercato unico digitale e pongono la persona al centro della regolamentazione, garantendo i suoi diritti personali e la sua dignità. Il regolamento sulla protezione dei dati personali riveste un ruolo centrale nell’AI Act, il quale riconosce l’importanza di una regolamentazione efficace per l’utilizzo responsabile dell’intelligenza artificiale. Ciò dimostra l’impegno dell’UE per la tutela dei diritti fondamentali dei cittadini nell’era digitale.

In base all’articolo 53 dell’AI Act, gli Stati membri devono garantire il coinvolgimento delle autorità nazionali per la protezione dei dati e delle altre autorità competenti nello spazio di sperimentazione normativa per l’IA, qualora i sistemi di IA innovativi prevedano il trattamento di dati personali o rientrino nell’ambito di competenza di tali autorità.

Tale coinvolgimento ha lo scopo di assicurare la tutela dei dati personali e il rispetto delle normative nazionali e internazionali in materia di IA.

Il Partito Democratico ha presentato una proposta di legge, con il primo firmatario Antonio Nicita, che prevede l’obbligo di etichettatura per i contenuti generati da intelligenza artificiale.

Questa proposta è motivata dal fatto che sempre più contenuti audiovisivi ed editoriali sono generati dall’AI e che è importante segnalare ciò a chi ne usufruisce per prevenire possibili manipolazioni dell’informazione o violazioni del diritto d’autore. Il disegno di legge, denominato “Disegno di legge sulla trasparenza dei contenuti generati da intelligenza artificiale“, mira a garantire la trasparenza dei contenuti generati dall’AI e a proteggere i diritti degli autori.

I “deep fake” sono contenuti audio, immagini o video manipolati o sintetizzati in modo da sembrare autentici o veritieri, ma che in realtà sono falsi. Questi contenuti utilizzano tecniche di intelligenza artificiale, come l’apprendimento automatico (machine learning) e l’apprendimento profondo (deep machine learning), come descritto nella proposta.

La proposta di legge prevede l’obbligo per i soggetti responsabili della pubblicazione e diffusione dei contenuti generati da intelligenza artificiale di garantire una riconoscibilità immediata agli utenti.

È stato proposto di introdurre un’etichettatura chiara e univoca per i contenuti generati da intelligenza artificiale. L’etichetta suggerita è “AI made/prodotto da intelligenza artificiale”.

L’Autorità per le garanzie nelle comunicazioni (Agcom) definirà i dettagli dell’etichettatura attraverso un proprio Regolamento, che sarà pubblicato entro 60 giorni dall’approvazione della legge. L’Agcom avrà il compito di monitorare e far rispettare le disposizioni della legge, segnalando e rimuovendo i contenuti pubblicati e diffusi in violazione di queste disposizioni e infliggendo sanzioni proporzionate alla gravità della violazione.

La Presidenza del Consiglio ha istituito una Commissione di indagine sulla possibile perdita di posti di lavoro correlata all’adozione di algoritmi di intelligenza artificiale.

La Commissione, presieduta da Giuliano Amato, avrà il compito di esaminare il fenomeno e redigere un rapporto per valutare quanti posti di lavoro sono a rischio, ad esempio nel settore dell’editoria e del giornalismo. Il governo potrà adottare contromisure a seguito del rapporto per prevenire la perdita di posti di lavoro.