Introduzione:

Nel mondo digitale in rapida evoluzione di oggi, le truffe online stanno diventando sempre più sofisticate, sfruttando le ultime tecnologie per ingannare gli utenti ignari. Un recente caso emerso in Italia ha messo in luce l’uso dell’intelligenza artificiale nelle operazioni di truffa, sollevando preoccupazioni significative sulla privacy e sulla sicurezza online.

Il Caso:

Una presunta truffa di proporzioni enormi è stata scoperta, coinvolgendo migliaia di utenti attraverso più di 400 siti web che promuovevano falsi investimenti su piattaforme di trading online. Questi siti garantivano guadagni facili e veloci, ma celavano una realtà ben diversa: una finta società di investimento che utilizzava indebitamente il logo e le immagini dei dirigenti di Eni, il colosso energetico nazionale.

Il Ruolo dell’Intelligenza Artificiale:

Per rendere la truffa ancora più convincente, i malintenzionati hanno fatto ricorso a programmi di intelligenza artificiale per generare video deep-fake. In questi video apparivano presunti esperti e testimonial che elogiavano le opportunità d’investimento offerte dalla piattaforma. L’uso dell’IA in questo contesto non solo dimostra la crescente accessibilità di queste tecnologie ma solleva anche interrogativi etici e legali sull’utilizzo improprio dell’immagine altrui.

Implicazioni per la Privacy e la Sicurezza Online:

Questo caso evidenzia la necessità di una maggiore consapevolezza riguardo ai rischi associati alle truffe online e all’uso dell’intelligenza artificiale. La capacità di creare contenuti falsi ma estremamente realistici pone sfide significative alla protezione della privacy individuale e alla sicurezza delle informazioni.

La collaborazione tra la polizia postale e la security di Eni ha permesso di bloccare l’attività truffaldina, ma il caso serve da monito per il futuro. È fondamentale che gli utenti siano educati a riconoscere i segni di possibili truffe e che si adottino misure preventive più robuste da parte delle aziende e delle autorità competenti. Inoltre, è essenziale promuovere un dibattito etico sull’uso dell’intelligenza artificiale, per garantire che il suo sviluppo avvenga in modo responsabile e a beneficio della società.

Implicazioni Giuridiche ed Etiche dell’Uso dei Deepfake nelle Truffe Online

L’intervento delle autorità, che ha portato al blocco di oltre 400 siti web promotori di falsi investimenti, evidenzia la crescente preoccupazione per l’uso dell’intelligenza artificiale nella creazione di contenuti ingannevoli, in particolare i video deepfake.

Questi ultimi rappresentano una sfida significativa per il diritto e la regolamentazione, poiché utilizzano l’IA per alterare video o immagini in modo da far apparire persone in contesti falsi o compromettenti.

La Tecnologia dei Deepfake:

I deepfake sfruttano algoritmi avanzati per sovrapporre visi o modulare voci su video esistenti, creando illusioni convincenti che possono ingannare gli spettatori facendoli credere a situazioni completamente false.

Sebbene questa tecnologia possa avere applicazioni innocue o creative, il suo utilizzo in contesti fraudolenti solleva questioni legali e morali urgenti, soprattutto quando contribuisce a diffondere false informazioni o a danneggiare la reputazione di individui.

Ripercussioni dei Deepfake:

L’utilizzo malintenzionato dei deepfake nelle truffe online non solo mette in pericolo la sicurezza finanziaria degli utenti ma può anche avere ripercussioni devastanti sulla vita privata delle persone rappresentate nei video falsificati.

Queste azioni possono portare a conseguenze legali per i creatori e i diffusori di tali contenuti, comprese accuse di diffamazione, violazione della privacy e frode.

Le Pericolose Conseguenze dei Deepfake sulla Società

Violazione della Privacy:

L’uso non autorizzato di volti o voci attraverso i deepfake costituisce una grave violazione della privacy individuale. Quando queste tecniche sono impiegate per inserire persone in contesti imbarazzanti o illegali, gli effetti possono essere devastanti. Le vittime dei deepfake possono subire molestie, minacce, ricatti, e un irreparabile danno alla propria immagine e dignità. La violazione della privacy in questi termini solleva questioni legali significative e richiede una risposta normativa adeguata per proteggere le persone.

Diffamazione e Danni alla Reputazione:

I deepfake possono anche essere utilizzati per diffamare individui o aziende, facendo apparire come se avessero detto o fatto qualcosa di offensivo o illegale. Questo può portare a gravi conseguenze, inclusa la perdita di onorabilità, credibilità, danni economici e potenziali azioni legali. La diffamazione tramite deepfake rappresenta una minaccia per l’integrità personale e professionale, sollecitando una riflessione sulla necessità di strumenti legali più efficaci per contrastarla.

Inganno del Pubblico e Manipolazione dell’Opinione:

Infine, l’utilizzo dei deepfake per scopi fraudolenti o per diffondere notizie false minaccia l’integrità dell’informazione pubblica. Questi contenuti possono alterare la percezione della realtà da parte del pubblico su eventi storici, politici o sociali, inducendo le persone a credere a menzogne, prendere decisioni sbagliate o sostenere cause ingiuste. La capacità dei deepfake di ingannare il pubblico solleva preoccupazioni urgenti sulla necessità di promuovere l’alfabetizzazione mediatica e di sviluppare tecnologie capaci di identificare e segnalare i contenuti falsificati.

Proprietà Intellettuale e Responsabilità: Sfide Legali dei Deepfake

L’impiego dei deepfake solleva questioni complesse in termini di diritti d’autore e proprietà intellettuale.

Quando queste tecnologie vengono usate per manipolare contenuti protetti da diritto d’autore o per imitare marchi registrati senza permesso, si infrangono le leggi sulla proprietà intellettuale.

La domanda su chi detenga i diritti su un contenuto deepfake – se l’autore originale, il creatore del deepfake, o nessuno dei due – è ancora aperta e richiede un’attenta considerazione legale per trovare una soluzione equa.

Imputazione della Responsabilità:

Determinare la responsabilità per la creazione e diffusione di deepfake rappresenta un’altra sfida significativa. La questione di chi sia responsabile – se solo l’autore del deepfake o anche la piattaforma che lo ospita – richiede di esaminare attentamente le politiche delle piattaforme e le leggi esistenti. È necessaria una collaborazione tra creatori, piattaforme, autorità legali e vittime per assicurare che i contenuti dannosi vengano rimossi, gli autori puniti adeguatamente, e le vittime protette e risarcite per i danni subiti.

Collaborazione tra Parti Coinvolte:

La lotta contro l’uso malevolo dei deepfake richiede una collaborazione stretta tra tutti gli attori coinvolti. Le piattaforme online devono rafforzare i loro meccanismi di verifica e rimozione dei contenuti deepfake dannosi, lavorando a stretto contatto con le autorità per identificare e perseguire i trasgressori. Parallelamente, è fondamentale sensibilizzare il pubblico sui rischi dei deepfake, promuovendo una maggiore consapevolezza digitale tra gli utenti.

Protezione e Risarcimento delle Vittime:

Infine, assicurare che le vittime di deepfake siano adeguatamente protette e risarcite per i danni subiti è cruciale. Ciò implica non solo l’adozione di misure legali per il risarcimento ma anche il supporto psicologico e sociale per aiutare le persone a superare le conseguenze di queste violazioni.

Incorporando il nuovo contenuto, possiamo estendere l’articolo per includere un caso specifico che mette in luce l’uso dei deepfake nel marketing online, sottolineando le implicazioni etiche e legali di tali pratiche. Ecco come potrebbe essere integrato:

L’Uso dei Deepfake nelle Pubblicità Online

La Polemica sul “Genie Script”:

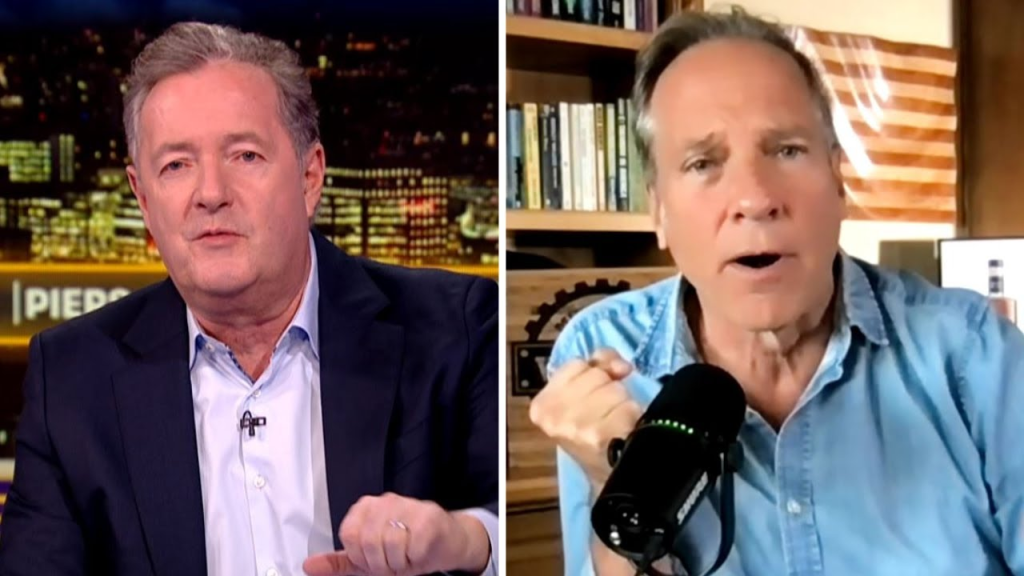

Un esempio recente dell’uso controverso dei deepfake riguarda celebrità come Piers Morgan, Nigella Lawson e Oprah Winfrey, che sono state falsamente rappresentate in pubblicità online per promuovere il “Genie Script”, un corso di auto-aiuto di Wesley “Billion Dollar” Virgin. Queste pubblicità utilizzavano l’intelligenza artificiale per creare l’impressione che queste celebrità avessero appoggiato il prodotto, generando una falsa credibilità intorno al corso venduto a 37 dollari.

Eticamente Discutibile e Legalmente Dubbio:

La pratica di utilizzare deepfake per manipolare l’immagine di celebrità al fine di promuovere prodotti o servizi solleva serie questioni etiche e legali. Oltre a violare i diritti di immagine delle persone coinvolte, queste pubblicità possono ingannare i consumatori, facendo leva sulla fiducia e l’ammirazione che il pubblico ha verso queste figure pubbliche. La diffusione di tali contenuti pubblicitari non solo danneggia la reputazione delle celebrità coinvolte ma minaccia anche l’integrità del mercato, inducendo i consumatori a prendere decisioni basate su informazioni false.

La Necessità di una Regolamentazione Più Stringente:

Questo caso evidenzia l’urgente necessità di una regolamentazione più stringente nell’uso dell’intelligenza artificiale per scopi pubblicitari. È fondamentale stabilire linee guida chiare che vietino la creazione e la diffusione di contenuti pubblicitari deepfake senza il consenso esplicito delle persone rappresentate.

Inoltre, le piattaforme online dovrebbero implementare meccanismi di verifica più efficaci per prevenire la pubblicazione di pubblicità ingannevoli.

È evidente l’esigenza di aggiornare il quadro legislativo per tenere il passo con le innovazioni tecnologiche.

Le leggi sulla privacy, sulla proprietà intellettuale e sulla responsabilità devono essere riviste e adattate per affrontare efficacemente i rischi associati ai deepfake.

Ciò include definire chiaramente la responsabilità degli autori di deepfake e delle piattaforme che li ospitano, garantendo al contempo la protezione delle vittime.

L’uso improprio dei deepfake nelle pubblicità online, come nel caso del “Genie Script”, sottolinea l’importanza di affrontare le sfide poste da queste tecnologie con un approccio olistico che coinvolga legislatori, industria tech, piattaforme di social media e il pubblico. Solo attraverso una collaborazione efficace e una regolamentazione adeguata sarà possibile proteggere l’integrità delle informazioni online e salvaguardare i diritti e la dignità delle persone.

Uso di Deepfake in Pubblicità Finge Endorsement di Nigella Lawson

Queste pubblicità utilizzano immagini e voci di celebrità note, come Nigella Lawson e Piers Morgan, per promuovere prodotti o servizi, facendo credere ingannevolmente che le celebrità siano direttamente coinvolte o approvino tali prodotti.

Nel dettaglio, una delle pubblicità menzionate finge che Nigella Lawson attribuisca il suo successo a una guida segreta rivelata da Wesley Virgin, utilizzando un’imitazione quasi indistinguibile della sua voce realizzata con AI.

Questa guida segreta sarebbe legata alla pratica della manifestazione, suggerendo che ripetendo un certo mantra si possano ottenere ricchezza e successo.

Un’altra pubblicità utilizza tecniche simili per manipolare filmati del programma televisivo “Piers Morgan Uncensored”, promuovendo un’antica scrittura che avrebbe il potere di attrarre ricchezze, guarigioni miracolose e amore.

Entrambe le celebrità, attraverso i loro portavoce, hanno denunciato queste pubblicità come fraudolente e hanno espresso preoccupazione per l’uso improprio della loro immagine e voce, sottolineando il rischio che il pubblico possa essere ingannato da queste pratiche.

Piers Morgan ha commentato che questo è un esempio di una tendenza preoccupante in cui i personaggi pubblici vengono utilizzati senza autorizzazione per fini di lucro, evidenziando il potenziale danno ai consumatori che potrebbero credere nell’autenticità delle approvazioni delle celebrità.

Questi annunci non solo sfruttano la fiducia e l’ammirazione che il pubblico nutre verso queste figure pubbliche, ma sollevano anche questioni legali e morali significative.

YouTube ha prontamente rimosso gli annunci in questione, citando la sua politica di lunga data contro l’uso di media manipolati per ingannare gli utenti.

Tuttavia, il fatto che tali contenuti siano apparsi in primo luogo evidenzia una sfida crescente: come possono le piattaforme digitali anticipare e contrastare efficacemente la diffusione di disinformazione sofisticata?

L’avanzamento delle tecnologie per la creazione di contenuti audiovisivi falsificati sta progredendo a un ritmo notevole, rendendo sempre più difficile distinguere i falsi dalla realtà.

In risposta a queste sfide, è fondamentale che le piattaforme sociali e i legislatori implementino misure più efficaci e proattive.

La reazione alle pubblicità deepfake che coinvolgono figure pubbliche come Oprah Winfrey ha sollevato importanti questioni riguardanti la protezione dei consumatori e l’uso etico dell’intelligenza artificiale.

Le squadre legali delle celebrità coinvolte hanno espresso preoccupazione per l’uso improprio della loro immagine, sottolineando l’importanza di salvaguardare l’autenticità e prevenire associazioni false.

Nel frattempo, piattaforme come Meta hanno agito per rimuovere contenuti che violano le loro politiche sulla disinformazione e l’uso improprio della tecnologia.

Wesley Virgin, al centro di questa controversia per le pubblicità generate dai suoi affiliati, ha affermato di aver preso misure per proibire tali pratiche pubblicitarie.

Tuttavia, l’attenzione rimane sulle strategie di marketing online e sul ruolo degli affiliati nel promuovere prodotti o servizi, sollevando questioni più ampie sull’etica nel marketing digitale e sulla responsabilità dei creatori di contenuti nel monitorare come la loro immagine e le loro risorse vengano utilizzate.

Le tecniche di marketing adottate da Wesley Virgin hanno suscitato ampio dibattito per le loro promesse eccessive e l’approccio controverso.

Attraverso pubblicità che vantano facili guadagni mediante l’azione di “copiare e incollare link”, Virgin mira a reclutare persone per promuovere i suoi prodotti, come il Genie Script, attraverso i social media. Questa strategia si basa sulla diffusione di link che indirizzano a pagine di vendita online, precedute da video promozionali caratterizzati da dichiarazioni iperboliche e narrazioni fuorvianti.

Particolarmente problematico risulta essere un video che allude a una ipotetica pagina “perduta” della Bibbia, la quale sarebbe detentrice di segreti per accumulare ricchezza noti soltanto all’élite. Questo contenuto è aggravato da minacce nei confronti di chi osasse divulgare tali segreti. Il video prosegue attribuendo la prosperità economica della comunità ebraica all’utilizzo di “segreti di manifestazione” derivanti da una versione antica e “non censurata” della Bibbia ebraica, veicolando così messaggi di natura antisemita.

Le pubblicità ingannevoli non si sono limitate a manipolare contenuti religiosi ma hanno anche coinvolto celebrità senza il loro consenso, tra cui Piers Morgan, Nigella Lawson e il canadese Kevin O’Leary. Quest’ultimo, attraverso un portavoce, ha dichiarato che le immagini utilizzate erano state acquistate da un sito web che vende messaggi personalizzati delle celebrità, sottolineando che sarebbero state prese misure per rimuovere il contenuto abusivo. O’Leary ha inoltre negato qualsiasi associazione con Virgin e le sue attività.

La piattaforma Digistore24, utilizzata per la vendita dei prodotti di Virgin, ha annunciato la fine del suo rapporto commerciale con lui, citando la violazione dei termini e delle linee guida relative all’uso dei link di affiliazione. Nonostante le critiche e le azioni intraprese da celebrità e piattaforme, Virgin sembra non essere dissuaso, continuando a promuovere il suo “sogno” di ricchezza attraverso i social media e sostenendo di poter insegnare alle persone come diventare milionari.

“Grandi Aziende Tech Unite per Combattere i Deepfake nelle Elezioni con Nuovo Quadro Globale”

Un consorzio di aziende tecnologiche di spicco, tra cui Google, Microsoft, OpenAI e altre 12 aziende, inclusa X di Elon Musk, ha firmato il “Tech Accord to Combat against Deceptive Use of AI in 2024 Elections” il 16 febbraio 2024 a Monaco. L’accordo mira a contrastare l’uso dei deepfake e altri contenuti ingannevoli generati dall’intelligenza artificiale nelle campagne elettorali, affrontando una crescente preoccupazione per l’integrità delle elezioni nel contesto digitale globale. Questa iniziativa risponde alla necessità di proteggere le elezioni del 2024, che coinvolgeranno una vasta porzione della popolazione mondiale e del PIL globale, dall’influenza dei deepfake e della disinformazione AI-generata.

Il quadro d’azione proposto stabilisce una strategia globale per prevenire la diffusione di informazioni false legate alle elezioni, enfatizzando l’uso dell’intelligenza artificiale come strumento difensivo per rilevare rapidamente campagne ingannevoli e migliorare i meccanismi di difesa. Promuove un approccio che coinvolge tutta la società, sollecitando la collaborazione tra enti governativi, aziende tecnologiche, società civile ed elettorato per preservare l’integrità elettorale e la fiducia pubblica. Attraverso sette obiettivi principali, il quadro enfatizza l’importanza di adottare misure proattive per identificare e contrastare i contenuti elettorali ingannevoli prodotti dall’IA, aumentare la consapevolezza pubblica e promuovere la resilienza attraverso l’educazione e lo sviluppo di strumenti difensivi.

Per raggiungere questi obiettivi, le aziende coinvolte hanno delineato strategie che includono lo sviluppo e l’implementazione di tecnologie avanzate per mitigare i rischi connessi ai contenuti deepfake. Questo approccio si concentra non solo sulla limitazione della diffusione di tali contenuti ma anche sul supporto all’innovazione tecnologica che faciliti l’identificazione tempestiva e la certificazione dell’autenticità delle immagini AI-generate. Inoltre, le aziende si impegnano a monitorare e controllare la diffusione di questi contenuti sulle piattaforme online, adottando misure adeguate per gestirli in maniera responsabile.

Un aspetto fondamentale di questo accordo è il rispetto dei principi di libertà di espressione e sicurezza. Le politiche adottate saranno coerenti e trasparenti, mirate a fornire al pubblico informazioni chiare sull’origine della ricerca e sugli aggiornamenti relativi ai contenuti. Inoltre, è previsto un processo di sensibilizzazione pubblica attraverso campagne educative, lo sviluppo di strumenti open source e la collaborazione con organizzazioni e comunità.

Queste iniziative rappresentano passi significativi verso la creazione di un ambiente digitale più sicuro e informato, dove i cittadini sono capaci di riconoscere e valutare criticamente i contenuti generati dall’intelligenza artificiale.

La collaborazione tra le principali aziende tecnologiche in questo sforzo dimostra un impegno condiviso nel proteggere l’integrità del discorso pubblico e nel promuovere una partecipazione informata e consapevole nell’ambiente digitale.

“Indagine in New Hampshire su Chiamate Robotiche AI che Imitano Biden per Sopprimere il Voto”

L’ufficio del procuratore generale del New Hampshire ha indagato su chiamate robotiche che utilizzavano l’intelligenza artificiale per imitare la voce del presidente Joe Biden, mirando a dissuadere gli elettori dal partecipare alle primarie. Queste chiamate, percepite come un tentativo illegale di interferire con il processo elettorale, sono state erroneamente attribuite al numero di Kathy Sullivan, ex presidente del Partito Democratico statale. Nonostante l’incertezza sul numero esatto di destinatari, si stima che almeno una dozzina di persone abbiano ricevuto la chiamata. Gli elettori sono stati esortati a ignorare il messaggio e a esercitare il loro diritto di voto.

La Casa Bianca e la campagna di Biden hanno negato qualsiasi coinvolgimento, promettendo azioni contro la diffusione di disinformazione. Esperti come Hany Farid avvertono che l’uso di IA generativa potrebbe presentare sfide senza precedenti in termini di disinformazione elettorale nel 2024. Il governo federale cerca ancora di regolamentare l’uso dell’IA in politica, con il Congresso che non ha approvato legislazioni specifiche nonostante il supporto bipartisan. La Commissione elettorale federale valuta proposte per regolare i deepfake in annunci elettorali.

Questo incidente riflette la crescente preoccupazione per l’uso manipolativo dell’IA nelle elezioni, evidenziando la necessità di vigilanza per proteggere l’integrità del processo democratico. La campagna di Dean Phillips, sfidante di Biden nelle primarie democratiche, e quella di Trump hanno entrambe negato qualsiasi coinvolgimento, condannando gli sforzi volti a scoraggiare gli elettori. Queste dinamiche sottolineano l’importanza di affrontare le sfide poste dall’IA per mantenere elezioni libere ed eque.

A rischio la credibilità delle campagne politiche

L’avanzamento dell’intelligenza artificiale generativa ha portato alla capacità di manipolare video e immagini con una precisione tale da rendere spesso indistinguibile il vero dal falso.

Questa capacità presenta rischi significativi per l’integrità delle campagne politiche, poiché la diffusione di informazioni false o manipolate può influenzare profondamente l’opinione pubblica.

Nel contesto delle elezioni su scala globale, il potenziale di tali manipolazioni si amplifica, mettendo a rischio la fiducia nell’intero sistema democratico. La capacità dei deepfake di influenzare l’orientamento degli elettori rappresenta una minaccia diretta al dibattito pubblico, alla trasparenza e all’autenticità che dovrebbero caratterizzare le campagne politiche.

Di fronte a questa sfida senza precedenti, è fondamentale riconoscere l’urgenza di sviluppare strategie efficaci per preservare l’integrità del processo democratico, garantendo che le informazioni condivise durante le campagne elettorali siano accurate e non alterate da tecnologie avanzate di manipolazione.

i precedenti

L’impiego di intelligenza artificiale per generare contenuti falsificati ha già avuto ripercussioni tangibili sul panorama democratico, dimostrato da almeno tre casi significativi.

Il primo episodio si è verificato in Slovacchia, durante le elezioni parlamentari di settembre 2023, con la diffusione di un audio manipolato che imitava la voce di Michal Šimečka, leader progressista, mentre apparentemente discuteva piani per manipolare il voto. Questo audio, diffuso ampiamente sui social media, ha evitato le politiche di controllo di Meta, creando disinformazione a ridosso del voto.

In Argentina, durante le elezioni presidenziali dell’ottobre 2023, è emerso un secondo caso con registrazioni audio false che attribuivano al candidato Carlos Melconian proposte indecorose in cambio di posizioni governative. Queste registrazioni hanno alimentato scandali e confusione tra gli elettori.

Il terzo caso ha visto protagonista una robocall che imitava la voce del presidente degli Stati Uniti Joe Biden, tentando di dissuadere gli elettori dal partecipare alle primarie del New Hampshire. Questo episodio ha evidenziato la crescente minaccia dei deepfake, soprattutto in vista delle elezioni presidenziali, sollevando preoccupazioni sull’accuratezza e la sofisticatezza con cui questi contenuti possono essere prodotti e diffusi.

Questi esempi sottolineano l’urgente necessità di affrontare l’utilizzo malintenzionato dell’intelligenza artificiale nella creazione di disinformazione, evidenziando come questa pratica possa non solo influenzare il risultato delle elezioni ma anche erodere la fiducia nei processi democratici.

La Sfida dei Deepfake: Vuoto Normativo e Tentativi di Regolamentazione negli USA

La questione del vuoto normativo negli Stati Uniti riguardo alla regolamentazione dei deepfake, soprattutto in contesti sensibili come le campagne elettorali, solleva preoccupazioni significative.

Nel 2023, solamente tre stati hanno adottato misure legislative per affrontare questa problematica, mentre altri sette stati hanno presentato proposte che non hanno tuttavia portato a cambiamenti concreti. Anche a livello federale, le proposte legislative avanzate sia dal Senato che dalla Camera per regolamentare l’uso dei deepfake nelle elezioni non hanno ottenuto progressi notevoli. Nonostante la Commissione Elettorale Federale abbia espresso l’intenzione di regolare i deepfake negli annunci elettorali, tali buone intenzioni non si sono tradotte in azioni efficaci.

In un tentativo di affrontare questa sfida, il presidente Joe Biden ha emesso un ordine esecutivo nell’ottobre dello scorso anno, incaricando il Dipartimento del Commercio di elaborare linee guida per il watermarking dei contenuti generati dall’AI. Questo sistema dovrebbe permettere di identificare i contenuti multimediali creati o modificati artificialmente. Tuttavia, questa soluzione presenta limitazioni, soprattutto per quanto riguarda video e immagini: i metadati possono essere alterati, rendendo il watermarking un metodo potenzialmente inefficace per garantire la trasparenza e l’autenticità dei contenuti.

Questo scenario evidenzia la necessità di un approccio più robusto e comprensivo per regolamentare l’utilizzo dei deepfake, sottolineando l’importanza di sviluppare strategie efficaci che vadano oltre le soluzioni tecniche per affrontare le sfide poste dalla disinformazione generata dall’intelligenza artificiale nelle arene politiche e sociali.

La crescente complessità dell’ambiente digitale, in cui si mescolano informazioni autentiche e manipolate, pone una sfida significativa all’integrità del processo democratico. In questo contesto, emerge l’importanza cruciale della collaborazione tra diversi attori, sia pubblici che privati, unitamente a iniziative normative mirate, per garantire che gli elettori possano navigare con sicurezza in questo panorama e fare scelte informate. L’implementazione di strategie ben congegnate, che includano lo sviluppo, la diffusione e il monitoraggio dei risultati, è fondamentale per mitigare gli impatti negativi che l’intelligenza artificiale generativa può avere sull’affidabilità delle informazioni disponibili al pubblico, specialmente in periodi critici come quello delle elezioni.

L’accordo firmato a Monaco rappresenta un passo nella giusta direzione, sottolineando l’importanza di prevenire e ridurre i rischi associati all’uso di AI generativa. Tuttavia, questo sforzo evidenzia anche la necessità di un impegno più ampio e coordinato a livello globale per contrastare efficacemente questa minaccia emergente. Solo attraverso un approccio congiunto e globale sarà possibile proteggere l’integrità delle informazioni e, di conseguenza, quella del processo democratico stesso.

Unendo le Forze Contro i Deepfake: La Collaborazione Globale per la Salvaguardia della Democrazia Digitale

La necessità di un’azione congiunta tra entità pubbliche e private emerge come cruciale per preservare l’integrità del processo democratico nell’era digitale.

L’implementazione di strategie mirate, che abbracciano lo sviluppo, la diffusione e il monitoraggio efficace, si rivela fondamentale per contrastare gli effetti destabilizzanti dell’intelligenza artificiale generativa. Queste tecnologie, capaci di creare contenuti falsificati indistinguibili da quelli autentici, rappresentano una minaccia significativa, specialmente in periodi critici come le campagne elettorali.

L’accordo raggiunto a Monaco, sebbene rappresenti un passo positivo verso la mitigazione di questi rischi, sottolinea l’urgenza di un impegno più ampio e globale. È essenziale rafforzare la collaborazione internazionale per affrontare questa sfida, garantendo così che gli elettori possano distinguere con precisione tra informazioni vere e manipolate, mantenendo la fiducia nel sistema democratico.

Deepfake e Sicurezza Informatica: La Truffa da 25 Milioni di Dollari che Cambia le Regole del Gioco”

Nel febbraio del 2024, un audace attacco informatico ha messo in luce la crescente minaccia rappresentata dai deepfake nel mondo della cybersecurity. Secondo quanto riportato dal South China Morning Post, degli hacker hanno orchestrato una truffa sofisticata sfruttando la tecnologia dei deepfake per impersonare il direttore finanziario e altri dipendenti di un’azienda. Mediante una videoconferenza falsificata, hanno indotto i partecipanti a trasferire circa 25,6 milioni di dollari su diversi conti correnti. Questo episodio non solo sottolinea la vulnerabilità delle organizzazioni di fronte a tattiche di inganno sempre più avanzate ma evidenzia anche il livello di realismo che i deepfake hanno raggiunto, rendendoli strumenti potenzialmente devastanti nelle mani sbagliate.

L’evento solleva questioni urgenti sulla sicurezza informatica e sull’importanza dell'”extended detection and response” (XDR), una strategia che i Chief Information Security Officers (CISO) devono valutare attentamente. L’XDR si concentra sull’identificazione e la risposta a minacce informatiche estese, combinando dati di sicurezza da più fonti per una protezione più efficace. La capacità dei deepfake di ingannare gli individui mette in evidenza la necessità per le aziende di adottare approcci di sicurezza olistici che vadano oltre le tradizionali difese perimetrali.

Questo caso di truffa dimostra che non è sufficiente affidarsi alla vigilanza dei dipendenti o alla sicurezza dei sistemi informatici esistenti. È fondamentale implementare tecnologie avanzate e formazione specifica per riconoscere e contrastare le minacce poste dai deepfake. Inoltre, la collaborazione tra aziende, esperti di sicurezza e legislatori è cruciale per sviluppare normative e soluzioni tecnologiche che possano prevenire futuri attacchi di questo tipo.

In conclusione, l’episodio serve da campanello d’allarme per le organizzazioni di tutto il mondo, sottolineando l’importanza di rafforzare le misure di sicurezza informatica e di prepararsi a fronteggiare le sfide poste dalle nuove tecnologie di manipolazione digitale.

Oltre la Fiducia Cieca: Deepfake e la Nuova Frontiera della Sicurezza Aziendale”

L’incidente riportato dal South China Morning Post, in cui un collaboratore ha effettuato bonifici ingenti seguendo istruzioni ricevute in video da presunti vertici aziendali, mette in luce una problematica sempre più pressante nel panorama della sicurezza informatica: la fiducia cieca nelle comunicazioni digitali. Il collaboratore, sebbene avesse perplessità, ha scelto di non mettere in discussione l’ordine ricevuto per rispetto delle gerarchie aziendali. Questo episodio sottolinea come il rispetto per l’autorità e la gerarchia possano diventare vulnerabilità sfruttabili da malintenzionati che utilizzano deepfake per impersonare figure di autorità.

In un’era in cui immagini e voci possono essere falsificate con una precisione tale da renderle quasi indistinguibili dagli originali, diventa imperativo riconsiderare il modo in cui valutiamo l’autenticità delle comunicazioni digitali. Questo scenario richiede un cambio di paradigma nella sicurezza informatica, dove la verifica dell’identità e la validazione delle richieste diventano aspetti fondamentali delle strategie di difesa aziendale.

La lezione da trarre è chiara: le organizzazioni devono evolvere le proprie politiche di sicurezza per includere formazione specifica sui rischi legati ai deepfake e allo stesso tempo implementare sistemi di verifica più stringenti per le comunicazioni interne, specialmente quando implicano decisioni finanziarie critiche. Questo caso evidenzia l’importanza di sviluppare una cultura aziendale che incoraggi il questionamento critico e la verifica delle informazioni, anche in presenza di apparenti autorità. La difesa contro le minacce informatiche rinnovate come i deepfake richiede non solo tecnologie avanzate ma anche un approccio olistico che includa educazione, consapevolezza e procedure robuste di autenticazione.

Oltre la Tecnologia: la Lotta Umana Contro le Truffe Digitali nell’Era dei Deepfake”

Nell’epoca digitale in cui viviamo, la tecnologia si è evoluta diventando uno strumento duplice: da un lato facilita le nostre vite quotidiane e dall’altro apre nuove porte a truffatori e cybercriminali. Come sottolineato dall’ingegner Sbaraglia, ciò che stiamo assistendo oggi con l’ascesa dei deepfake e delle truffe online non è altro che una moderna reinterpretazione di raggiri ben più antichi. Un esempio emblematico è il caso del 2019 che ha coinvolto Maire Tecnimont, dove truffatori, attraverso conference call simulate, hanno sottratto 16 milioni di euro fingendosi alti dirigenti aziendali. Queste operazioni di inganno sono classificate come Business E-mail Compromise (BEC), e in particolare, quando mirano ai vertici aziendali, vengono definite “CEO Fraud” o “Business Executive Scam”.

La peculiarità di queste truffe non risiede tanto nell’uso di tecnologie avanzate, quanto piuttosto nell’abilità di sfruttare la debolezza umana. Infatti, l’ingegner Sbaraglia evidenzia come la difesa più efficace contro tali frodi non sia necessariamente tecnologica. Piuttosto, la formazione dei dipendenti e l’adozione di procedure aziendali rigorose rappresentano la chiave per mitigare i rischi. Questo include l’istituzione di controlli di pagamento severi, con una chiara separazione dei ruoli per prevenire conflitti di interesse e garantire che le responsabilità di autorizzazione, esecuzione e verifica dei pagamenti siano adeguatamente distribuite.

Inoltre, è fondamentale stabilire protocolli obbligatori di verifica per i pagamenti importanti, come le telefonate di controllo a chi dovrebbe autorizzare le transazioni, utilizzando canali di comunicazione sicuri e verificati. Questo approccio sottolinea come la lotta contro il Business E-mail Compromise richieda un focus sul fattore umano, rafforzando la consapevolezza e le competenze dei dipendenti per prevenire e contrastare efficacemente queste minacce.

In conclusione, mentre la tecnologia continua a evolversi e i deepfake diventano sempre più sofisticati, la vera battaglia si gioca sul terreno della formazione e delle procedure interne. Solo attraverso un impegno costante nell’educare il personale e nel rafforzare le politiche aziendali sarà possibile creare un ambiente lavorativo più sicuro e resiliente alle truffe digitali.

Conclusioni

Concludendo, il caso italiano di truffa online mediata dall’uso di deepfake segna un punto di svolta nella percezione pubblica e nella consapevolezza dei rischi associati all’intelligenza artificiale applicata in maniera fraudolenta. L’impiego di video deep-fake per promuovere falsi investimenti non solo sottolinea l’avanzamento tecnologico raggiunto da queste tecniche di manipolazione, ma solleva anche questioni profonde riguardo alla sicurezza, alla privacy e all’etica digitale.

La crescente accessibilità delle tecnologie di intelligenza artificiale che permettono la creazione di contenuti falsificati ma estremamente realistici, come i deepfake, richiede una risposta multidimensionale. È imperativo che utenti, aziende, legislatori e comunità tecnologica collaborino per sviluppare strategie efficaci di prevenzione, educazione e intervento. La formazione degli utenti nel riconoscere segnali di possibili truffe e l’implementazione di robusti protocolli di sicurezza da parte delle aziende diventano fondamentali per mitigare i rischi.

Parallelamente, è essenziale promuovere un dibattito etico sull’utilizzo dell’intelligenza artificiale, affrontando le implicazioni legali dell’uso improprio di immagini e voci altrui. La legislazione deve evolvere per tenere il passo con le sfide poste da queste tecnologie, garantendo che chi utilizza i deepfake a scopi fraudolenti o diffamatori possa essere efficacemente perseguito.

In ultima analisi, la lotta contro l’abuso dei deepfake nelle truffe online testimonia la necessità di un equilibrio tra innovazione tecnologica e responsabilità etica. Mentre esploriamo le potenzialità dell’intelligenza artificiale, dobbiamo anche garantire che il suo sviluppo e utilizzo avvengano in modo che tuteli l’integrità individuale e collettiva, preservando i valori fondamentali della nostra società.

La strada da percorrere è complessa, ma con un approccio collaborativo e proattivo, possiamo aspirare a un futuro digitale più sicuro e eticamente responsabile.